عقبنشینی اپل از اجرای طرح تشخیص CSAM دردسرساز شد. آنطور که مشخص است یکی از کاربران شکایت سنگینی علیه غول فناوری آمریکایی مطرح کرده است.

چند سال پیش یعنی در سال 2021، اپل اعلام کرد طرح جدیدی را تشخیص CSAM به iCloud اضافه میکند؛ اما مدتی بعد انتقادات مطرح شده باعث شد که غول فناوری آمریکایی از افزودن این قابلیت صرفنظر کند. طبق گزارشی که techcrunch منتشر کرده همین موضوع باعث شده که پای این شرکت به دادگاه کشیده شود.

اجرا نکردن طرح تشخیص CSAM برای اپل دردسرساز شد

ماجرا از این قرار است که یکی از قربانیان که زنی 27 ساله است، شکایتی مبنیبر اجرا نکردن طرح اسکن تصاویر در iCloud برای تشخص CSAM علیه اپل مطرح کرده است؛ اما داستان به همین سادگی نیست.

این قربانی میگوید که در کودکی توسط یکی از آشنایانش مورد آزارجنسی قرار گرفته است و از اپل برای لغو این طرح و حمایت نکردن از قربانیانی مثل او، شکایت کرده است. یکی از وکلای این قربانی میگوید که شکایت مطرح شده با هدف تغییر سیاستهای ای شرکت و پرداخت غرامت به حدود 2 هزار 680 قربانی واجد شرایط دیگر مطرح شده است.

بر اساس قانون فعلی، برای چنین جرایمی 150 هزار دلار جریمه در نظر گرفته شده و اگر در این شکایت، اپل موفق نشد باید حدود یکمیلیارد و ۲۰۰ میلیون دلار جریمه به قربانیان پرداخت نماید. این اولین باری نیست که چنین شکایاتی علیه غول فناوری آمریکایی مطرح میشود.

چندی پیش یعنی در آگوست امسال، چند وکیل به نمایندگی از قربانی که دختری 9 ساله بود، شکایتی را علیه اپل مطرح کردند. این دخنر میگوید که غریبههایی لینک ویدیوهای CSAM مختلف را از طریق iCloud برای او ارسال کرده و او را به تولید ویدیوهایی از این قبیل سوق میدادند.

سخنگوی اپل نیز با انتشار بیانیهای به این موضوع واکنش نشان داد:

محتوای کودکآزاری نفرتانگیز است و ما متعهد به مبارزه با روشهایی هستیم که از طریق آن سوءاستفادهگران کودکان را در معرض خطر قرار میدهند. ما برای مبارزه با این جرایم بدون به خطر انداختن امنیت و حریم خصوصی کاربران خود، فوری و فعالانه دست به نوآوری زدهایم.

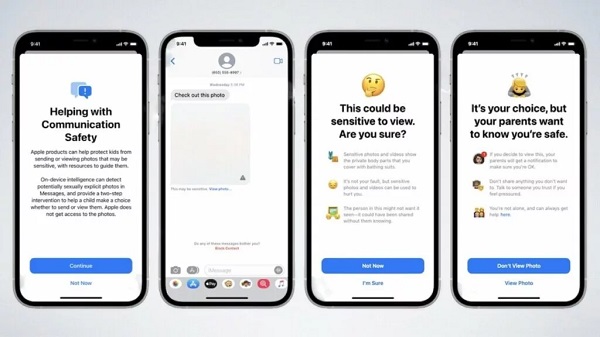

سخنگوی این شرکت برای دفاع به ویژگی مانند «ایمنی ارتباطات» (Communication Safety) در اپلیکیشن Messages اشاره کرده است. آنطور که مشخص است این قابلیت در محتواهایی که حاوی برهنگی هستند به کودکان هشدار میدهد تا آنها را آگاه کرده و از آزار آنها جلوگیری کند.

بیشتر بخوانید: